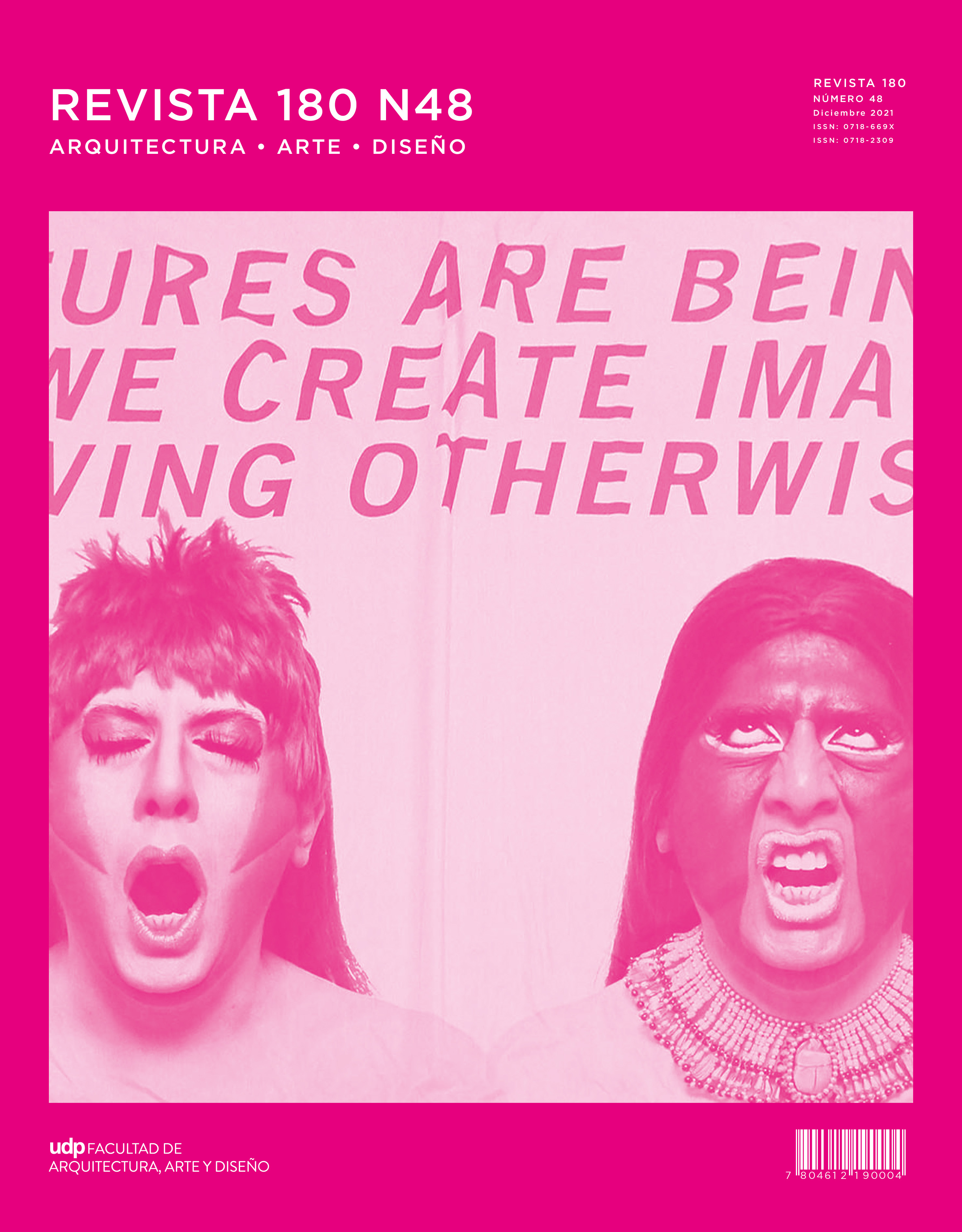

DISCRIMINACIÓN Y COLONIALIDAD EN LA VISIÓN ALGORÍTMICA. ABORDAJES ARTÍSTICOS PARA UNA REVISIÓN CRÍTICA DE LA CLASIFICACIÓN DE PERSONAS

Publicado 31-12-2021

Palabras clave

- algoritmos,

- discriminación,

- estadística,

- objetivismo,

- vigilancia

Cómo citar

Resumen

A la luz de propuestas artísticas con medios digitales y, específicamente, con inteligencia artificial, en este artículo se analiza críticamente la discriminación de personas en modelos de aprendizaje de máquinas; en particular, en aquellos modelos de clasificación diseñados para cumplir tareas de vigilancia y control social. Para ello, se propondrá en primer lugar que, según una versión filosófica del objetivismo, distintos modelos algorítmicos pretenden clasificar “objetivamente” a las personas en función de sus rasgos corporales, vinculándolas con perfiles psicológicos y de comportamiento. La dudosa relación que aquí se cuestionará es aquella que se basa en rasgos visibles y características invisibles de las personas, forjada por una mirada colonial que se reproduce actualmente en el funcionamiento de la visión algorítmica. En segundo lugar, se afirmará que esta discriminación se materializa en el mismo diseño de los modelos de clasificación. Por un lado, se abordará la importancia de la estadística para el funcionamiento del aprendizaje de máquinas en la perspectiva de sus relaciones históricas con prácticas policiales de vigilancia y control social; y, en segundo lugar, se analizará cómo aquella mirada colonial se reproduce en los conjuntos de datos y en los nombres de las categorías bajo las cuales las imágenes son etiquetadas y clasificadas, determinando así la realidad percibida algorítmicamente por estos modelos de clasificación.